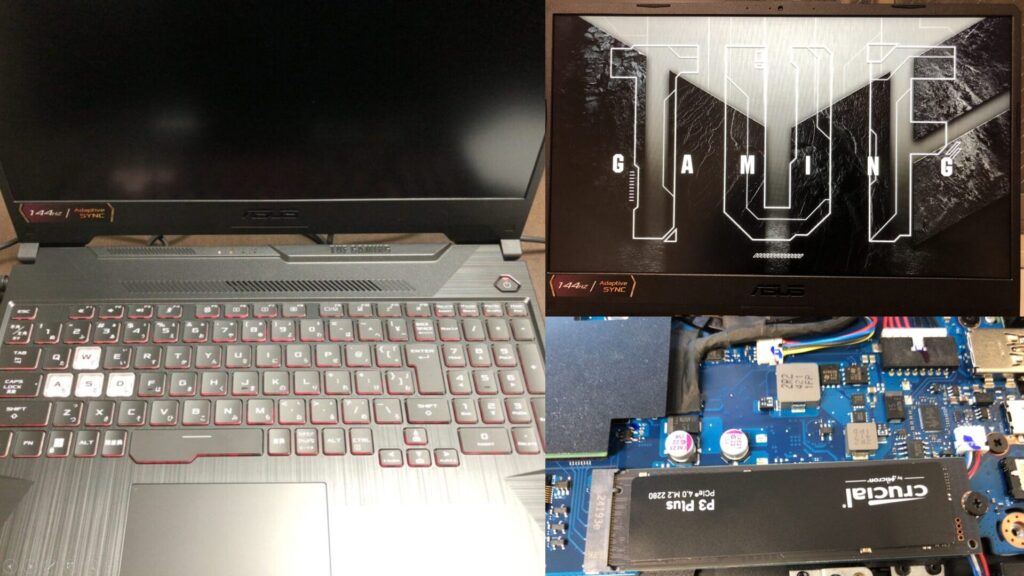

ちょっと買い物:ノートPCのメモリ交換(ASUS TUF Gaming A15、gpt-oss-20b)

はじめに

今回はいつも使っているノートPCのメモリを交換して、16GBから64GBに増やしてみました。

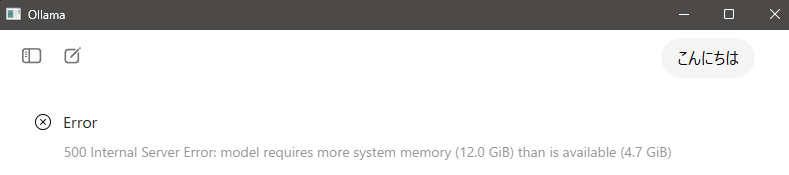

リリースされたばかりのgpt-oss-20bをローカルで実行したときにメモリが足りなかったので、これを機に交換することにしました。

▼メモリが足りないというエラーが起きています。

▼gpt-ossのニュース記事にも書かれていますが、メモリは16GB必要です。

https://openai.com/ja-JP/index/introducing-gpt-oss

はじめてのメモリ交換ですが、SSDを交換したときと同じように、簡単に交換できました。

▼PCは10万円ぐらいで購入したゲーミングノートPCを利用しています。Windows 11の環境です。

システムの確認

SSDを増設したときはCrucialという会社のものを購入しましたが、今回もCrucialのものを購入することにしました。

▼以下のページからダウンロードできるCrucialのスキャンツールでPCの型番を調べたうえで、対応しているメモリを選びました。

https://www.crucial.jp/store/systemscanner

▼スキャンツールを管理者権限で実行したところ、現状のメモリと利用できるメモリの一覧が表示されました。

▼私の場合、以下のページから対応しているものを選択できました。

ASUS ASUS TUF Gaming A15 FA506NC | メモリとSSDのアップグレード | Crucial JP

最大が64GBだったので、今回は64GBで高速なものを購入することにしました。

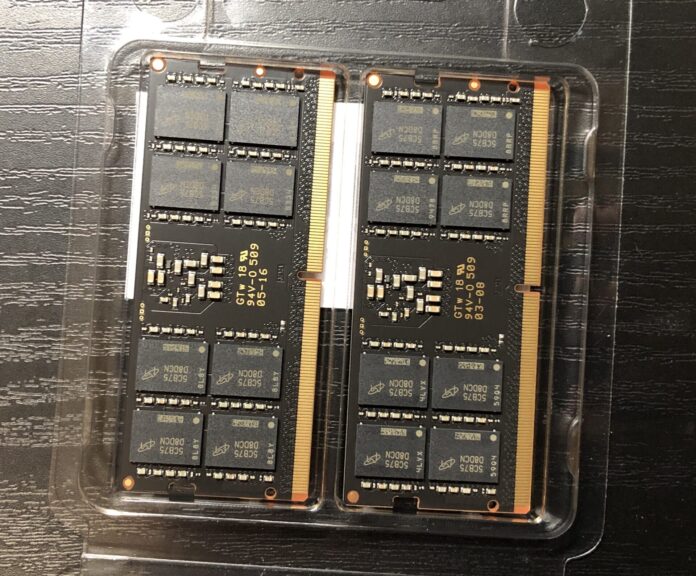

▼こちらの商品を購入しました。32GBが2枚で64GBですね。

▼16GBが2枚で32GBという選択肢もあります。

メモリの交換

実際に購入したものと交換してみました。

▼開封するとこんな感じ。

SSDの増設時と同様に交換します。

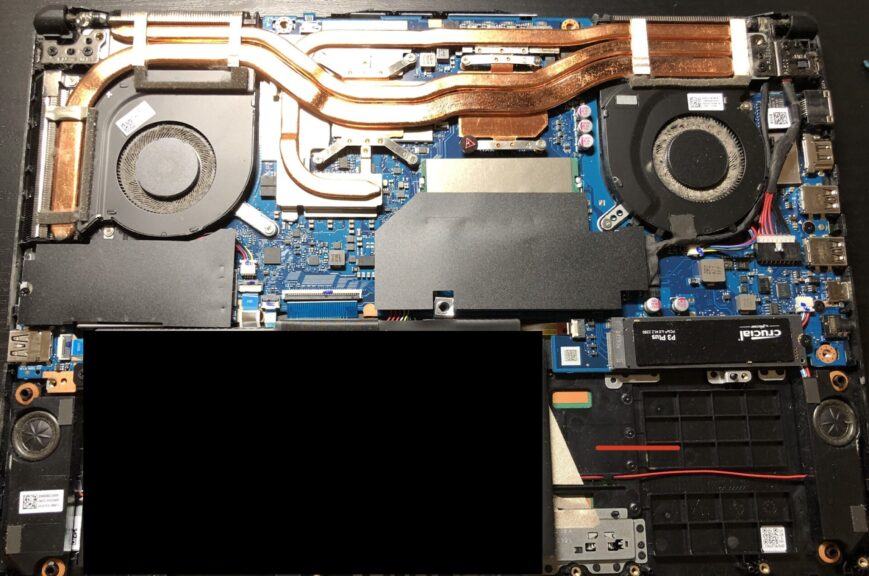

▼半年ぶりにノートPCの底面を外したのですが、かなり埃がたまっていました。これを機に清掃もしておきました。

▼ファン周りは特に埃が溜まっていました。定期的に清掃する必要がありそうですね。

▼コーナンなどでも販売されているエアダスターでほこりを除去しました。1~2か月に一回ぐらい分解して清掃するようにしています。

メモリは中央にありました。

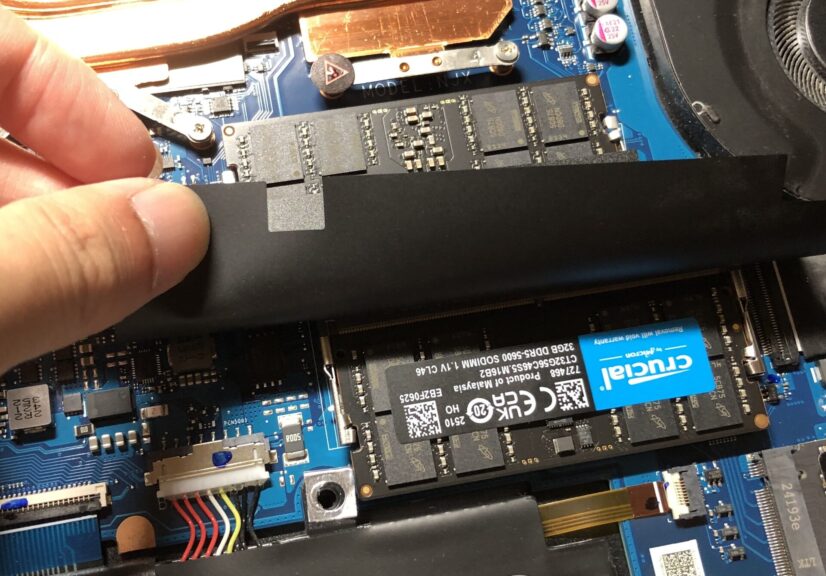

▼ツメを外すと簡単に外れました。

▼購入したメモリに取り替えました。

メモリの交換後、起動してみました。

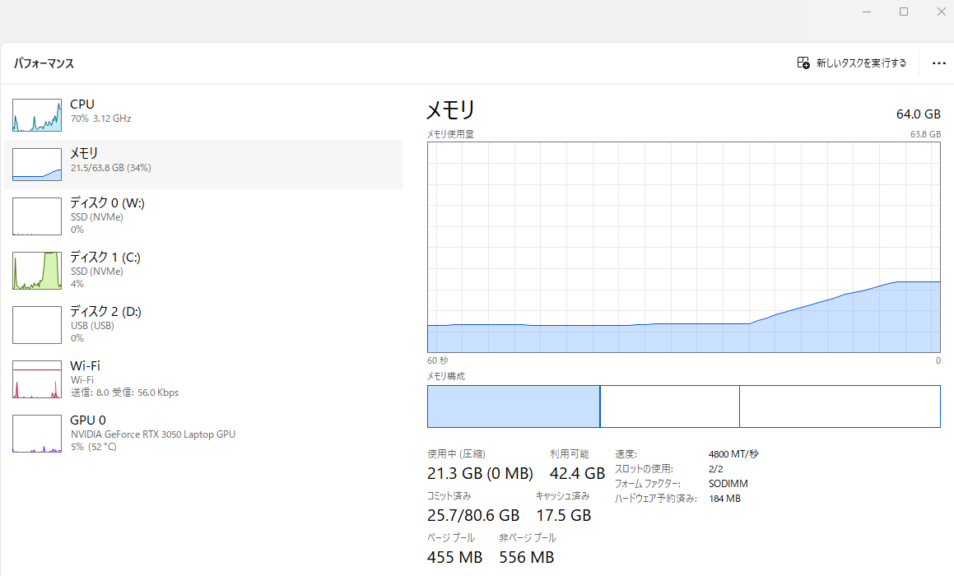

▼いつもより少し時間が経ってから起動して、タスクマネージャーを見るとメモリが64GBとして認識していました。

特に設定の必要もなく、差し替えるだけで簡単に交換できました。

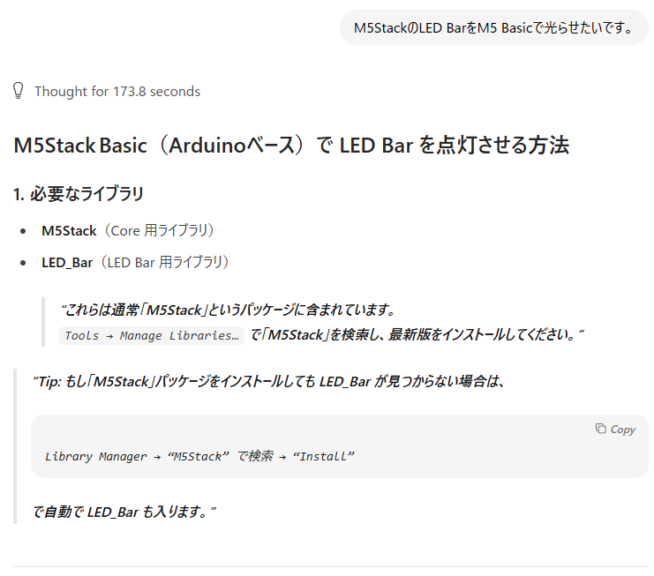

gpt-oss-20bを実行してみる

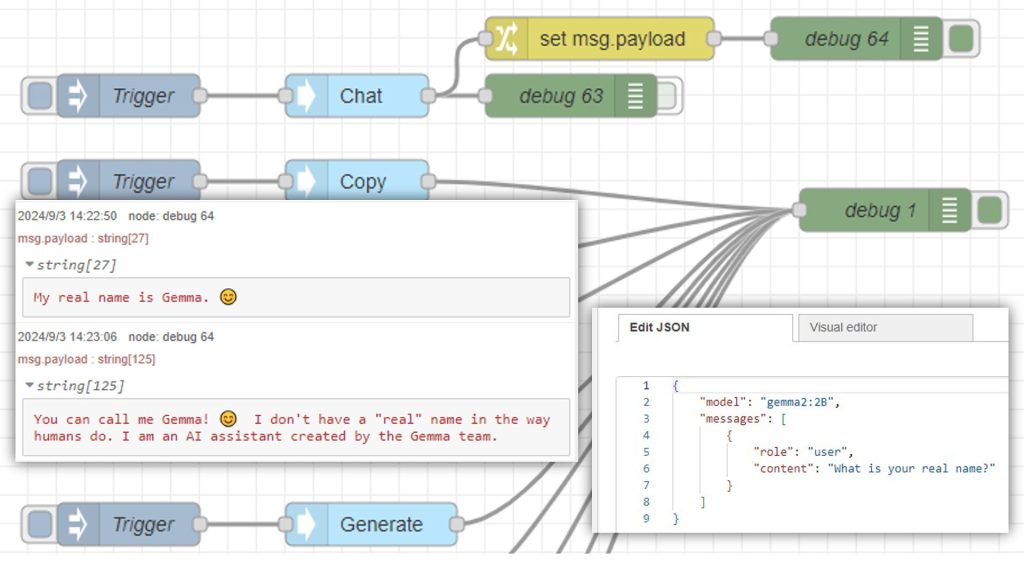

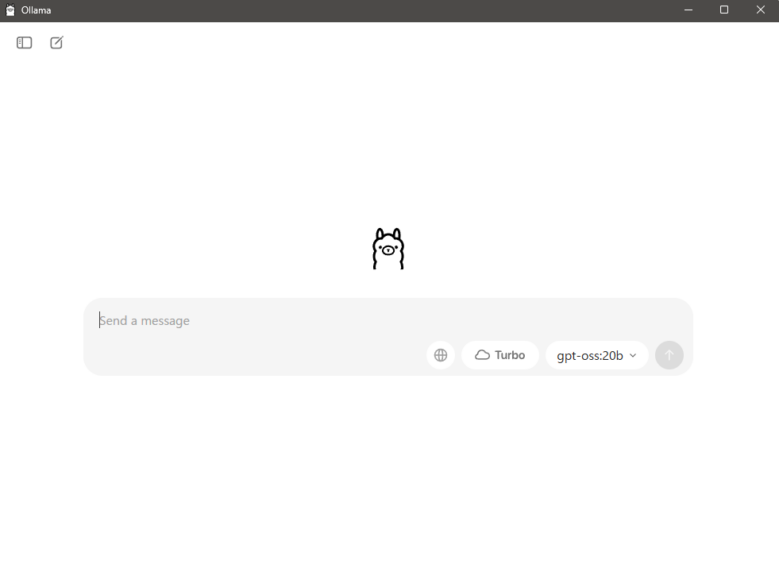

Ollamaでgpt-oss-20bを実行してみました。

▼Ollamaについては以下の記事でインストールしました。

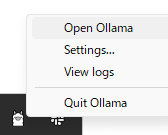

▼OllamaのGUIアプリが用意されていることを最近知りました。Open Ollamaで開けます。

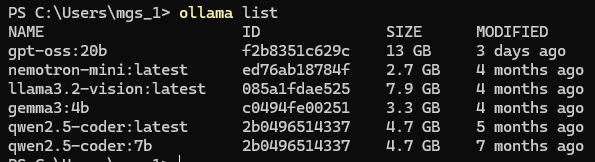

▼gemma3:4bの日本語が自然なのでよく使っているのですが、それよりも大きいですね。

質問してみたところ、数秒経って回答が返ってきました。日本語は問題なさそうです。

▼メモリには余裕があります。

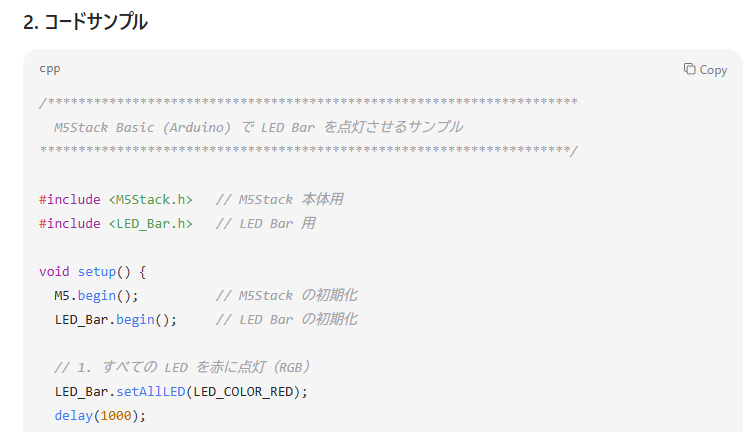

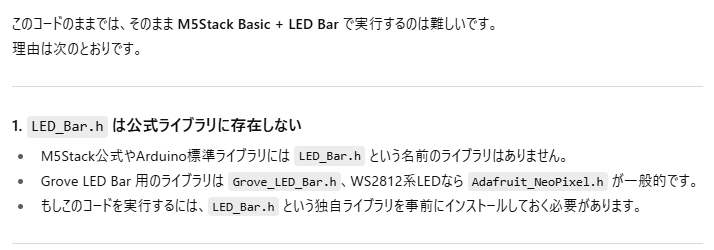

マイコンのコードを書いてもらったのですが、存在しないライブラリをincludeしていたので実行できなさそうでした。

▼さすがにブラウザのChatGPTと比較すると時間がかかります。

▼ちょうど同時期に利用できるようになったGPT-5に聞いてみたのですが、やはり存在しないようでした。

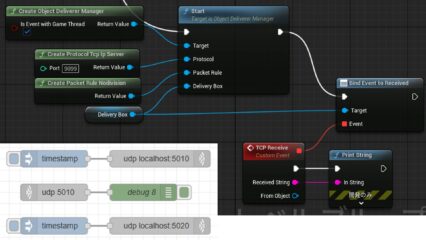

GPT-5に書いてもらった場合も、M5Stackの最新のライブラリに対応したコードでは無かったので、検索機能を併用してやっと実行できました。アップデートの激しいライブラリを利用しているマイコン関連のコードは苦手な印象があります。

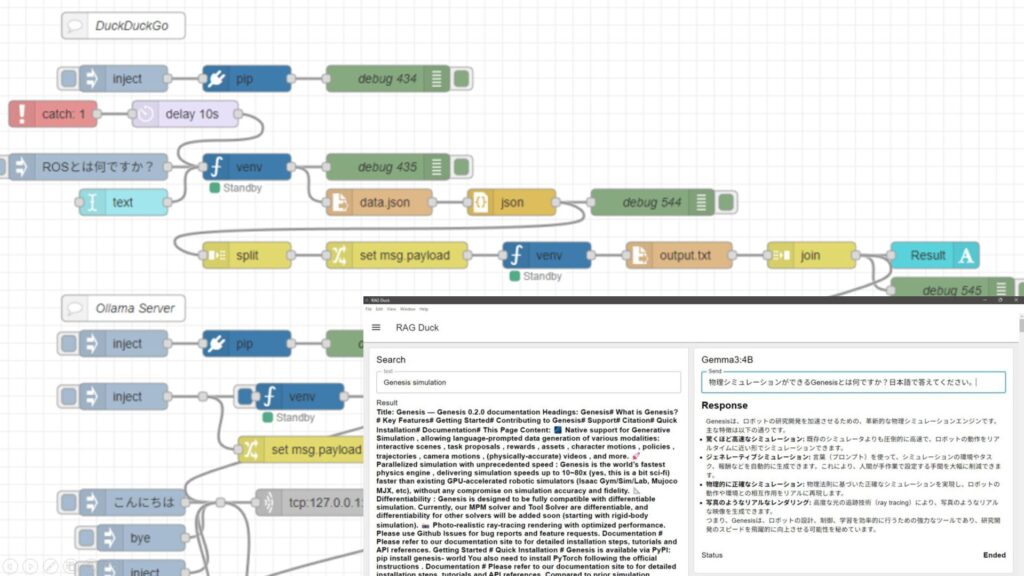

gpt-oss-20bでも検索機能を有効にしてみたのですが、なかなか終わらないような感じでした。要約とか文章作成の相談などをローカルで実行するにはちょうどいいのかな?という感じです。

最後に

最近Fusion 360の動作が遅いなと思っていたのですが、ソフトウェアを色々起動していると、使用メモリが32GBを超えていました。今まで16GBで動作させていたのはかなり無理があったようです。今では快適に動作しています。メモリを交換しておいて良かったです。

CPUとGPUは据え置きなのでAI関連の処理速度にはあまり期待できませんが、時間がかかってもいいので自動的に処理するのにローカルLLMを活用したいなと思っています。

▼RAGのようなものをNode-REDで構築したことがあります。